"Deep learning" et Robert ?

27/08/2014

La lexicographie est un sous-ensemble de la reconnaissance d'image...

Dans l'informatique d'aujourd'hui, le "dictionnaire" est "caché"... derrière Word chez Microsoft, derrière la messagerie, le correcteur orthographique rectifie aujourd'hui assez bien les erreurs de frappe ou les fautes d'orthographe. Dans les tablettes, les propositions de mot lors de la frappe des premières lettres fonctionnent aussi avec un "dictionnaire".

En France, il est interdit de copier un "dictionnaire" comme le Robert. Tout nouveau créateur se doit donc d'innover, lorsqu'il crée un nouveau Dictionnaire.

Microsoft décide donc de créer le sien (en français) dans les années 2000 avec une spécialiste des dictionnaires et une équipe d'une trentaine de lexicographes, qui firent sur la tranche allouée une redéfinition des mots (50.000 au total). Ce dictionnaire de français était disponible dans l'Encyclopédie Encarta... puis désormais à travers les applications principales de bureautique !

La grandes maisons (Larousse, Robert et autres) livrent aussi leur dictionnaire sous forme informatique, mais n'utilisent pas leur trésor dans les applications informatiques...

L'image, aujourd'hui, est un nouvel enjeu, tant elle s'est multiplié, avec les smartphones ! Le souci, qui est vieux comme le monde, est de trier ou d'extraire les informations pertinentes. A l'université Dauphine, dans les années 70, l'Armée planchait déjà sur la reconnaissance automatique des images de "chars", pour évaluer rapidement leur puissance de feu ! Aujourd'hui, les visages, les marques, ainsi que les méta-données, qui accompagnent les images (positionnement géographique, auteur, date) sont autant d'éléments significatifs, qui nécessitent des logiciels très performants, des bases de données fort bien organisées pour en faire quelque chose !

Un bon dessin vaut mieux qu'un long discours !

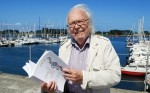

Alain Rey, l'amoureux des mots

Télégramme du 27 août 2014

Alain Rey, rédacteur en chef du dictionnaire Le Robert, vient passer, depuis 15 ans, ses vacances à l'Aber-Wrac'h, où il possède une maison. À presque 86 ans, le linguiste conserve intact son amour de la langue française qu'il aime voir évoluer et s'enrichir.

À l'Aber-Wrac'h, Alain Rey aime s'installer, en compagnie de son épouse, au Café du port quand il n'observe pas de sa fenêtre les mouvements des bateaux qui rejoignent ou quittent le port. « Émile Littré, connu pour son Dictionnaire de la langue française, est venu lui aussi à l'Aber-Wrac'h dans les années 1870 pour se détendre », souligne-t-il. Le poète russe Alexandre Blok et Céline ont, eux aussi, aimé l'aber. Ce lieu serait-il pour les grands mots le grand remède ?

Alain Rey a oublié son âge et travaille sans relâche sur l'univers des mots. « C'est un peu par hasard. Alors que j'avais fait mes études d'histoire de l'art et Science Po, je suis tombé sur une annonce de Paul Robert qui recherchait des collaborateurs pour l'élaboration d'un nouveau type de dictionnaire. J'ai trouvé mon bonheur ». S'il voit dans le Larousse un dictionnaire encyclopédique, il précise la différence avec le Robert : « Nous essayons de donner la dimension culturelle de la langue française, plus historique, humaniste ».

« Savoir comment les gens parlent »

Pour lui, dans un dictionnaire, l'essentiel est l'ouverture d'esprit par rapport à la société. « Il faut voir comment les gens parlent vraiment. Celui qui donne une norme c'est celui de l'Académie française. J'ai mis au point un système, avec les éditions du Robert, qui permet de le faire vivre par rapport au rythme de la langue. La langue évolue vite et le français est pluriel. Je ne parle pas des langues mais des expressions régionales qui le colorent, que très peu de langues connaissent dans le monde ».

150 mots nouveaux chaque année

Et les mots nouveaux ? « C'est une question de bonne observation de l'évolution réelle du langage. Notre dictionnaire est un observatoire mais pas un conservatoire. Nous introduisons plus de 150 mots ou expressions nouvelles chaque année, un choix par rapport à un millier possible. Si une majorité de Français les pratique, il faut les introduire. Le livre d'Hervé Lossec sur les bretonnismes était dans la bibliothèque du Robert au lendemain de sa parution ». Il ajoute : « Dans les mots nouveaux, il y avait "zlatané " que tous les gosses emploient dans les cours de récréation. Nous ne l'avons pas mis. "vuvuzela " ne se dit plus beaucoup mais je l'ai vu réapparaître dans les matchs de foot ! Nous avons en bibliothèque le bouquin sur l'arsenal de Brest mais nous ne pourrons en utiliser les mots car ils sont trop spécifiques. Quant à "selfie", nous ne pouvons l'éviter car utilisé dans le monde entier ! ».

Les vertus du bilinguisme

Et la langue bretonne dans tout ça ? Les langues régionales sont, pour lui, une richesse qui a servi à donner des couleurs à la langue française. « J'étais content quand, en 2001, la Délégation à la langue française et aux langues de France a acquis la seconde partie de son appellation. C'est déjà un pas en avant. On a beaucoup de progrès à faire par rapport aux autres pays européens. En Italie, comme en Allemagne, chacun parle sa langue régionale et nationale. C'est mieux pour l'identité culturelle. Je crois beaucoup aux vertus du bilinguisme, il y a une formation humaine qui est meilleure. Pour faire survivre une langue, il faut y mettre le paquet : il faut voir le fric que les Irlandais ont mis pour défendre leur langue avec les émissions de télé et de radio ! C'est une décision politique ! ».

Le dernier ouvrage d'Alain Rey « Le voyage des mots », joliment calligraphié par Lassaâd Metoui, évoque l'enrichissement de la langue française par des mots persans, arabes et turcs (éditions Trédaniel). Quand les marins bretons vêtus de leur caban lisent leur almanach en subissant la houle, ils peuvent se consoler en buvant un verre d'alcool produit par un alambic : ils seront alors au zénith et pourront faire un baroud d'honneur. Tous ces mots viennent des pays cités et ont été confirmés par les académiciens. Ce livre, loin d'être austère, fait partager le plaisir qu'a eu son auteur à voyager dans le monde des mots.

La reconnaissance d'images, nouveau terrain de jeu des géants du Net

Les Echos du 25 août 2014

Amazon et eBay investissent dans cette technologie, qui séduit les annonceurs.

Ils cherchent à analyser grâce à elle les photos postées sur les réseaux sociaux.

C'est un petit bouton, à gauche de l'écran. Il s'appelle Firefly, et Amazon en a fait l'un des principaux moteurs de son entrée sur le marché des smartphones, lors de la présentation de son Fire Phone en juin dernier. Il suffit de pointer le téléphone vers un livre, un CD ou un jeu vidéo et un lien direct apparaît pour l'acheter sur la plate-forme d'e-commerce, s'il est disponible en ligne.

Cette nouvelle fonction, extension de l'application Flow créée par Amazon il y a deux ans, repose sur la reconnaissance d'images. Amazon n'est pas le seul à s'intéresser à cette technologie. eBay a déjà mené plusieurs expériences similaires avec ses applications eBay Motors et eBay Fashion, qui permettent de proposer des vêtements ou des véhicules proches de ceux pris en photo.

Les fournisseurs historiques de ces technologies, de leur côté, travaillent avec plusieurs grandes enseignes qui cherchent une alternative au QR, ce code-barre destiné à être flashé par les smartphones « qui ne s'est jamais vraiment démocratisé », estime Guillaume Faure, de l'agence digitale Fabernovel. LTU Technologies, un des leaders français du secteur, a fourni la fonction « scan and find » (scanne et trouve) de l'application de l'enseigne de prêt-à-porter Celio, qui permet de rechercher un vêtement similaire à celui d'une photo. Zalando, le site Web allemand spécialisé dans la vente de vêtements et chaussures, vient de lancer une application similaire. Le fournisseur espagnol Catchoom mise lui sur la réalité augmentée, en permettant de voir en 3D les meubles du catalogue Ikea.

Mais les applications de reconnaissance d'images ne s'arrêtent pas à l'e-commerce : reconnaissance faciale, robotique, traduction ou encore publicité, le marché total est évalué à 9,65 milliards de dollars par le cabinet Markets and Markets. Il devrait croître de 21,6 % par an sur les cinq prochaines années, pour atteindre 25,65 milliards de dollars en 2019. De quoi aiguiser les appétits des géants du Net. Passée un peu inaperçue au milieu de l'été, l'acquisition par Google de Jetpac, une start-up qui analyse les photographies postées sur les réseaux de partage comme Instagram ou Flickr, confirme l'intérêt du géant de Mountain View pour cette technologie. Il y a un an et demi, Google avait déjà racheté DNN Research, une start-up de Toronto spécialisée dans ce domaine.

« Hashtags passifs »

« L'image s'impose désormais comme le moyen de communication dominant sur le Web », avance Frédéric Jahard, le PDG de LTU Technologies pour expliquer l'intérêt des GAFA (Google, Apple, Facebook, Amazon). Le nombre de smartphones ne cesse d'augmenter, et avec eux les photographies partagées sur les réseaux sociaux. 1,8 milliard de photographies sont partagées chaque jour sur Facebook, Instagram, Flickr, Snapchat et Whats-App, soit six fois plus qu'il y a deux ans, selon la dernière étude de KPCB sur les tendances sur Internet. Cette masse d'images a permis d'améliorer une technologie qui n'est pas nouvelle, mais qui restait encore peu efficiente.

« Le taux de réussite de la reconnaissance d'images est passé de 40 à 70 % il y a environ trois ans, grâce au progrès du "deep learning ", des algorithmes qui cherchent à simuler le fonctionnement de l'activité neuronale du cerveau humain », raconte Frédéric Jahard.

Les réseaux sociaux, qui ont misé sur l'image comme Tumblr ou Pinterest, pourraient trouver grâce à la reconnaissance d'images une manière de se monétiser. Rarement accompagnées de textes, les photos partagées sur leurs plates-formes créaient jusqu'ici peu de métadonnées. Ditto Labs, une entreprise américaine qui vient de nouer un partenariat avec Tumblr, promet de révéler leurs « hashtags passifs » : en clair, elle passe au crible les photographies en ligne pour analyser la présence des marques. Häagen-Dazs sait ainsi que ses glaces sont consommées en majorité à 1 h du matin. Et Vera Bradley que ses sacs à main sont régulièrement offerts comme cadeaux d'anniversaire aux adolescentes.

Anaïs Moutot, Les Echos

16 commentaires

Quelle est la définition de verbiage dans les différents dictionnaires ?

Et celle de ridicule ?

Monsieur Jeanbart,

Comme presque toujours dans ce blog, votre dialectique a pour but de justifier des prises de positions qui sont avant tout le fruit de votre affect et non celui d'une analyse rationnelle des faits considérés.

Pour nous convaincre, vous utilisez à peu près continuellement les mêmes procédés.

Vous tentez tout d'abord généralement de nous impressionner (nous étourdir, nous assommer…) avec une expression bien savante dont la signification exacte échappe évidemment au commun des lecteurs. Ici c'est : le "Deep learning"! Le but est évidemment de créer chez le lecteur un sentiment d'infériorité, devant quelqu'un qui sait des choses que lui, le lecteur, ne sait pas.

Ensuite, vous assénez au lecteur ainsi conditionné (rendu vulnérable…) un aphorisme bien senti qui se veut incontestable. Ici c'est : "La lexicographie est un sous-ensemble de la reconnaissance d'image..."

Eh bien, par exemple, cet aphorisme, je le conteste vivement. Dût en souffrir votre propension à ne voir dans beaucoup d'activités humaines qu'un sous-produit de l'informatique ! Tout comme vous semblez d'ailleurs considérer que le bonheur sur terre ne peut être qu'un sous-produit de l'économie libérale...

La lexicographie étudie les mots en tant qu'éléments qui permettent l'expression de la pensée. La reconnaissance d'image dont vous parlez, qui est à ranger dans le domaine de l'iconographie, permet seulement de véhiculer de l'information par une représentation simplifiée de la réalité. Une représentation qui ne fait appel qu'à l'un de nos sens : la vue. La photographie d'un corps de femme n'est pas un corps de femme ! C'est d'ailleurs ni plus ni moins ce qu'a voulu nous expliquer Magritte, à sa façon. "La trahison des images" : quelle belle expression, riche de sens !

L'iconographie a donc pour caractéristique de tronquer l'information. Elle a aussi pour caractéristique d'être incapable de transmettre la pensée. Elle transmet de l'information, éventuellement de l'émotion… mais de la pensée, non !

D'après vous, "un bon dessin vaut mieux qu'un long discours !". J'aimerais bien que vous me dessiniez la morale de Kant !!!

Bref, pour moi, la lexicographie, qui étudie les éléments qui permettent l'expression de la pensée, n'est absolument pas à classer comme un sous-ensemble d'une technique qui consiste simplement à extraire des éléments d'information d'images qui sont déjà par elle-mêmes une simplification de la réalité.

Monsieur Jeanbart, vous voudriez nous faire croire que c'est une pipe qu'il y a sur le tableau de Magritte. Eh bien, vous vous trompez !

Merci, votre démonstration n'en est pas une ! En matière de lexicographie, l'informatique a fait le tour de la question dans les années 2000... pour l'image, et votre référence à Magritte est significative, le contenu et son interprétation sont délicats ! Comment peut-on se souvenir d'un lieu, d'un objet, d'un visage, sans passer par une description ? l'intérêt des recherches actuelles est de se passer d'identifiant, comme le nom de famille, de la personne sur une image...on rentre ici dans le domaine probabiliste, qui échappe à beaucoup d'humains, qui ne pratiquent pas le bridge...

alors, bon courage, nous sommes dans ce domaine au temps de la préhistoire !

Il m'aurait étonné que vous reconnaissiez une part de vérité dans ce que j'ai écrit précédemment. Mais pour montrer votre désaccord, vous n'êtes pas obligé de déformer ce que j'ai écrit.

Je ne conteste pas l'importance de l'outil informatique en lexicographie. Je conteste simplement et précisément le bien-fondé de votre affirmation selon laquelle "la lexicographie est un sous-ensemble de la reconnaissance d'image". C'est très précisément le terme "sous-ensemble" qui me choque. En revanche, vous auriez parlé de techniques comparables utilisées dans les deux cas, que ça ne m'aurait pas choqué.

L'outil informatique permet effectivement de mesurer maintenant de façon objective l'occurrence des différents mots utilisés dans une langue, ainsi d'ailleurs que l'occurrence de leurs combinaisons les plus fréquentes. C'est un fait que je ne conteste pas. Ce même outil informatique permet aussi maintenant de mesurer l'occurrence de certains items contenus dans les images ainsi que l'occurrence de leurs principales combinaisons. Je ne le conteste pas non plus.

Mais pourquoi vouloir faire de la lexicographie informatisée un sous-ensemble de la reconnaissance d'image. Ca vous défriserait d'admettre que la lexicographie a existé bien avant l'informatique, qu'elle utilise maintenant cet outil mais qu'elle n'est en rien un sous-ensemble de la reconnaissance d'image, même si elles utilisent toutes deux des processus informatiques comparables ?

Reste maintenant que je continue de penser que les mots ont un contenu informatif globalement plus important que les images parce qu'ils véhiculent la pensée des humains, ce que sont incapables de faire les images. Un journal comme "Le Monde" a longtemps véhiculé une information de grande densité, sans jamais utiliser la moindre photographie. Vous ne répondez d'ailleurs pas à ma proposition de mettre les textes de Kant en images…

Monsieur Pier, vous avez tout à fait raison mais vous vous fatiguez pour rien car Monsieur Hennel (comme plusieurs personnes de ma connaissance je n'appellerai jamais ce petit jean-Foutre du nom d'un grand corsaire) est indécrottable. Je ne pense pas qu'il ait compris votre démonstration et c'est pourquoi il la réfute.

Il a un jour appris à utiliser windows et crois que ça lui est monté au cerveau et qu'il se prend depuis pour un grand informaticien.

Le problème avec les ordinateurs est qu'il suffirait d'une tempête solaire particulièrement forte pour ne plus en avoir du tout. Ce serait le chaos total et si cette tempête dure assez longtemps ce qui est une probabilité ...."plus que probable " (sic) ce serait le retour à l'ignorance, les catastrophes, les famines et ce ne sont pas les joueurs de bridge qui pourraient sauver le monde mais les manuels, les artisans, les paysans, les "primaires" que ce monsieur si fier de sortir d'HEC méprise tellement. Ce serait aussi ceux qui savent encore lire des livres, s'il y en a encore dans les bibliothèques

Jérémie, vous ne lisez pas assez ! La probabilité d'un cataclysme nucléaire est beaucoup plus probable qu'un "drame solaire" !

La révolution "informatique", que vous êtes en train de vivre, vous échappe peut-être par manque de maîtrise et d'expérience...

La "terre" et l'esprit paysan sont plus rassurant !

Pour la (n+1) ème fois, je vais te demander d'apporter une preuve, si minime soit-elle, à cette affirmation péremptoire concernant les probabilités comparées de deux événements. Sans me faire la moindre illusion quant à mes chances d'obtenir une réponse.

Mais bien sûr, je n'ai pas ta "maîtrise" ni ton "expérience" de ces domaines complexes.

Par contre, je sais que tu aurais dû mettre un "s" à "rassurant".

Enfin, si "la probabilité d'un cataclysme - qu'est-ce que tu caches derrière ce mot- nucléaire te paraît si grande, comment as-tu pu proposer la construction d'une centrale à quelques kilomètres de chez toi?

Et pour finir, j'aurais mis

Un article très intéressant à propos de l'intelligence artificielle :

http://www.lopinion.fr/6-juillet-2014/revanche-deep-learning-14113

Le "big data" et ses règles d'extraction ne sont qu'ne simple extrapolation de la recherche de données "significatives". Le "Deep Learning" est à l'opposé de ce concept, il ne repose par sur l'accélération des moyens techniques pour parvenir à un résultat ! mais sur l'apprentissage intelligent de règles de fonctionnement. Un petit fils de l'intelligence artificielle, qui pour l'instant produit des résultats médiocres...

Hennel tu débloques comm' d'hab'.Tu ne me connais pas et tes élucubrations sur l'informatique me font marrer car tu utilises des mots comme le font les petits enfants qui apprennent un mot nouveau et compliqué et fiers de leurs nouvelles connaissances le répètent à tout bout de champ de façon souvent erronnée

Tu fais du word dropping pédant comme d'autre font du name dropping, mais méfie toi, tu tape souvent à côté

----------------------------------------

Pour en revenir au deep learning. Pour ceux qui ne savent pas ce que ça veut dire :

« C’est un ensemble de techniques informatiques utilisant des données brutes pour apprendre sans supervision humaine », explique Sylvain Peyronnet, professeur en algorithmique à l’Université de Caen. « C’est comme si un enfant apprenait à lire tout seul et que l’adulte n’intervenait que pour lui dire " tu n’as pas compris " ou " tu as compris ". Mais sans lui avoir fourni l’alphabet », ajoute notre chercheur.

Ce n’est pas sa seule particularité. « Ce système de connaissance s’inspire de la neurobiologie. Il vise à trouver des éléments informatiques permettant à un réseau de neurones artificiels d’apprendre sur le modèle du cerveau humain », souligne Alain Cardon, chercheur en informatique avancée et intelligence artificielle à l’école d’ingénieurs de l’INSA. Expérimenté dans les labos dès la fin des années 70, le deep learning a mis du temps a émerger. Les premiers résultats ont été obtenus en améliorant les algorithmes et la puissance de calcul des ordinateurs.

------------------------------------------

les big data :

Les big data, littéralement les « grosses données », ou mégadonnées , parfois appelées données massives3, désignent des ensembles de données qui deviennent tellement volumineux qu'ils en deviennent difficiles à travailler avec des outils classiques de gestion de base de données ou de gestion de l'information. L'on parle aussi de datamasse4 en français par similitude avec la biomasse.

----------------------------------------------

C'était un petit apparté pour tes pauvres lecteurs

revenont à tes écrits

De quelle catastrophe nucléaire parles tu ? de celle qui nous menace du fait des centrales que tu aimes tant et dont nous avons eu déja plusieurs fois un aperçu ou celle d'un conflit nucléaire et dans ce cas, mon p'tit bonhomme, tu dates car il y a belle lurette qu'on sait que les explosions atomiques créent un champ electro magnétique intense qui fait sauter processeurs, ordis, "transistors". Ce fut un temps un secret militaire qui a été dévoilé quelques années plus tard, mais il y a déja bien longtemps.

alors que ce soit une catastrophe nucléaire ou une tempête solaire comme celle qui a failli toucher la terre il y a peu , ou celle qui a bloqué le canada, la probabilité d'en subir est réelle et ta fameuse accélération des moyens techniques nous mène directement dans le mur.

Il suffit de voir le résultat sur la bourse de l'utilisation des ordinateurs qui a aidé les spéculateurs à la détourner de son but premier qui était d'aider les entreprises en leur amenant des liquidités. Maintenant c'est une entreprise de paris (pas la capitale mais les spéculations)

En tout cas quand tu as faim tu peux toujours essayer de boulotter ton clavier, ça ne te nourrira pas beaucoup et tu sera content qu'il y ait un paysan qui cultive de quoi te nourrir .

j'oubliais

Lexicographie

La lexicographie est la science qui consiste à recenser les mots, les classer, les définir et les illustrer, par des exemples ou des expressions, pour rendre compte de l'ensemble de leurs significations et de leurs acceptions au sein d'une langue, afin de constituer un dictionnaire.

--------------------------------------------

sous-ensemble

On dit qu'un ensemble A est inclus dans un ensemble B si tous les éléments de A sont aussi éléments de B. On dit dans ce cas que A est un sous-ensemble ou une partie de B

--------------------------------------------

reconnaissance d'image on dit reconnaissance de forme

La reconnaissance de formes (ou parfois reconnaissance de motifs) est un ensemble de techniques et méthodes visant à identifier des motifs informatiques à partir de données brutes afin de prendre une décision dépendant de la catégorie attribuée à ce motif1. On considère que c'est une branche de l'intelligence artificielle qui fait largement appel aux techniques d'apprentissage automatique et aux statistiques.

---------------------------------------

PPier a raison ton sous-titre sentencieux EST un aphorisme, mais un aphorisme absurde . il n'y a comme presque toujours aucune cohérence entre ton titre, ton sous-titre, , ton texte et les articles

Jérémie ne fait pas avancer le débat ! pour lui, tout est sentence polémique...

Comme il travaille au milieu de dictionnaires savants, l'essentiel lui échappe !

L'écriture est au début "une image", dont l'apprentissage dure des années jusqu'au CP. Ce travail, recommencé par chaque être, peut être comparé à celui de l'apprentissage du déchiffrage "musical", qui est du même ordre : reconnaître les caractères, leur assemblage, puis le transformer en geste (la touche de piano).

La reconnaissance de l'écriture cursive est fortement aidée par la lexicographie, qui examine la fréquence d'apparition des mots dans leur contexte. mais il faut reconnaître aujourd'hui un taux d'échec d'environ 10% dans cette discipline, qui est donc écartée de tous les processus d'automatisation...

C'est en ce sens, lorsqu'il n'y a pas d'ambiguïté de reconnaissance avec l'utilisation de caractères ASCII, que la "lexicographie" est un "sous-ensemble" de la reconnaissance d'image...

Une phrase célèbre, qui est insoluble dans la reconnaissance "lexicographique" : les poules du couvent couvent !

tu écris, tu parles, tu juges sans savoir ni connaitre. Je me sers de dictionnaires numériques et papier de temps en temps et là, je voulais seulement que tes lecteurs connaissent les définitions exactesdes mots dont tu te gargarises et que tu utilises à si mauvais escient.

Je persiste et signe : ton titre et ton sous-titre sont ridicules et non appropriés à ce que tu écris ensuite. De plus, ta petite phrase exemple (phrase que j'utilise beaucoup pour indiquer la difficulté de l'orthographe française à mes amis étrangers) , démontre bien que ton affirmation pompeuse, "La lexicographie est un sous-ensemble de la reconnaissance d'image...", est totalement fausse pour la langue française ainsi que pour beaucoup d'autres car notre belle langue n'est pas la seule à être pleine d'ambiguïtés.

Je me demande pourquoi je prends la peine d'écrire ici. Tu parles/écris exactement comme le patient paranoïaque et bi-polaire d'un de mes amis. Avec lui jamais de débat mais des leçons pompeuses...... un serpent qui se mord la queue !

Monsieur Jeanbart,

Il est regrettable que vous n'ayez pas bien pris conscience de la signification du mot lexicographie. Jeremie en a pourtant donné une définition tout à fait satisfaisante, qui correspond à ce que l'on trouve justement dans la plupart des dictionnaires de la langue française.

Il est d'ailleurs savoureux que vous parliez de lexicographie sans avoir exactement compris le sens de ce mot puisque la lexicographie consiste justement à définir exactement le sens des mots. Il convient même de parler plus exactement de significations des mots, pour bien marquer le pluriel (ce que ne permet pas toujours le mot "sens", surtout quand il est utilisé sans article) puisque la très grande majorité des mots d'une langue ont plusieurs acceptions, c'est à dire des significations différentes, qui dépendent du contexte dans lequel ils sont utilisés.

Dans ce que vous dites, vous réduisez la lexicographie à l'identification des mots, à leur classement, et à leur utilisation pour différents usages, comme la correction orthographique ou la traduction dans une autre langue. Ce n'est cependant pas cela qui donne du sens aux mots. Ce qui leur donne du sens, ce sont les définitions qui leur sont attachées.

A ce jour, et vraisemblablement pour très longtemps encore, aucun système informatique n'est à même de donner des définitions précises aux mots. Les définitions des mots que vous trouvez actuellement, sur internet ou ailleurs, sont élaborées par des êtres humains et non par des machines, si sophistiquées soient-elles dans leur programmation. On ne peut en effet espérer définir des mots que si on connaît la société des hommes qui les utilisent et notamment ce qu'on appelle leur culture. Cet aspect culturel, subtil et évolutif, n'est pas prêt d'être intégré dans les systèmes informatisés.

Les systèmes informatisés de correction orthographique ou de traduction ne "comprennent" pas le sens de ce qu'ils corrigent ou traduisent. Ils travaillent sur des bases de données qu'ils manipulent de façon certes rapide et efficace mais ils ne pourront jamais effectuer le travail de compréhension que l'Homme est capable de faire… parce qu'ils ne peuvent pas intégrer l'ensemble du bagage culturel acquis par l'ensemble d'une société !

Evidemment on peut rêver à des machines informatiques qui auront un grand bagage culturel, éprouveront des émotions, seront conscientes de leur existence et prendront des initiatives, comme dans le cas expliqué ci-dessus, le 1er avril dernier !

http://dailygeekshow.com/2014/04/01/le-premier-cas-de-conscience-dune-intelligence-artificielle-debranchee-de-justesse-par-des-scientifiques-americains/

Cet aspect culturel qui s'attache aux mots et en particulier à leur(s) définition (s) font que certains d'entre eux sont intraduisibles dans une autre langue. On est alors obligé de les remplacer par un ensemble de mots, voire un élément de phrase parfois relativement long.

Je réécoutais récemment une chanson de Brassens dans laquelle il utilise le mot "jarnicoton". Il serait impossible de comprendre la signification et tout le charme de ce terme si des érudits ne nous avaient pas transmis l'histoire et notamment la "petite" histoire de France, remontant à Henri IV ! Pour que des ordinateurs soient capables d'effectuer un tel travail de retour sur le passé, il faudra d'abord introduire toute l'histoire du monde dans leur mémoire… et ensuite qu'ils soient capables d'en extraire de façon pertinente les informations utiles à la compréhension des mots. Encore une fois, ce n'est pas pour demain !

Chapeau bas monsieur Pier

Un dernier complément d'information et j'en aurai fini sur ce sujet.

Un groupe d'universitaires de Chicago, amoureux de la langue française, a étudié l'occurrence des différents mots de cette langue, dans un échantillon de près de 3000 textes français écrits depuis le XVIème siècle. Dans ce travail, l'occurrence est exprimée par le nombre de fois où le mot recherché apparaît dans un ensemble d'un million de mots.

Pour voir l'évolution générale des préoccupations de ceux qui publient des écrits, on peut s'amuser à rechercher comment l'occurrence des différents mots français a évolué au cours des temps.

Prenons par exemple le mot "république". Contrairement à ce à quoi on pourrait s'attendre, ce n'est pas au XXème siècle que l'occurrence de ce mot est la plus forte. Son utilisation a connu en fait deux pics de fréquence : vers 1720 puis vers 1800.

Pour comprendre cela, il est indispensable de savoir que, sous le règne de Louis XV, les principales significations de ce mot étaient très différentes de celles que nous lui attribuons aujourd'hui. Le mot république était alors notamment utilisé pour désigner un ensemble d'êtres partageant un sort commun. Les détails des anciennes significations du mot république sont donnés ici :

http://www.cnrtl.fr/definition/r%C3%A9publique

En 1800 (sous la première République française), le mot fait une réapparition en force mais, dès lors, avec une signification principale qui est celle que nous lui attribuons aujourd'hui.

Si vous voulez voir comment l'occurrence des mots français a évolué au cours des siècles, voici le site dont je parle :

http://dvlf.uchicago.edu/mot/r%C3%A9publique

En ne perdant donc pas de vue que les mots ont des acceptions multiples…

P.S. Ce deuxième lien est intéressant pour connaître l'évolution de l'occurrence des mots français. Sur le plan de la définition des mots, il est loin de valoir le site auquel donne accès mon premier lien.

Cordialement

Les commentaires sont fermés.